Un futuro digital seguro, la Ley Europea de IA y sus cuatro niveles de riesgo

En un mundo en el que la tecnología avanza a un ritmo sin precedentes, la necesidad de equilibrar la innovación con la seguridad nunca ha sido más crítica, se realizó una charla organizada por la Comisión de Tecnología, Innovación y Transformación Digital del CAI en conjunto con la Unión Europea para profundizar en la Ley Europea de Inteligencia Artificial, una pieza legislativa innovadora destinada a equilibrar la innovación tecnológica con la protección de los derechos fundamentales y la seguridad de los ciudadanos europeos.

La charla fue impartida por el Embajador de la Unión Europea en Argentina, Amador Sánchez Rico, quien habló en profundidad sobre la Ley Europea de IA que fue aprobada recientemente por el Parlamento Europeo, brindando una perspectiva autorizada sobre la legislación.

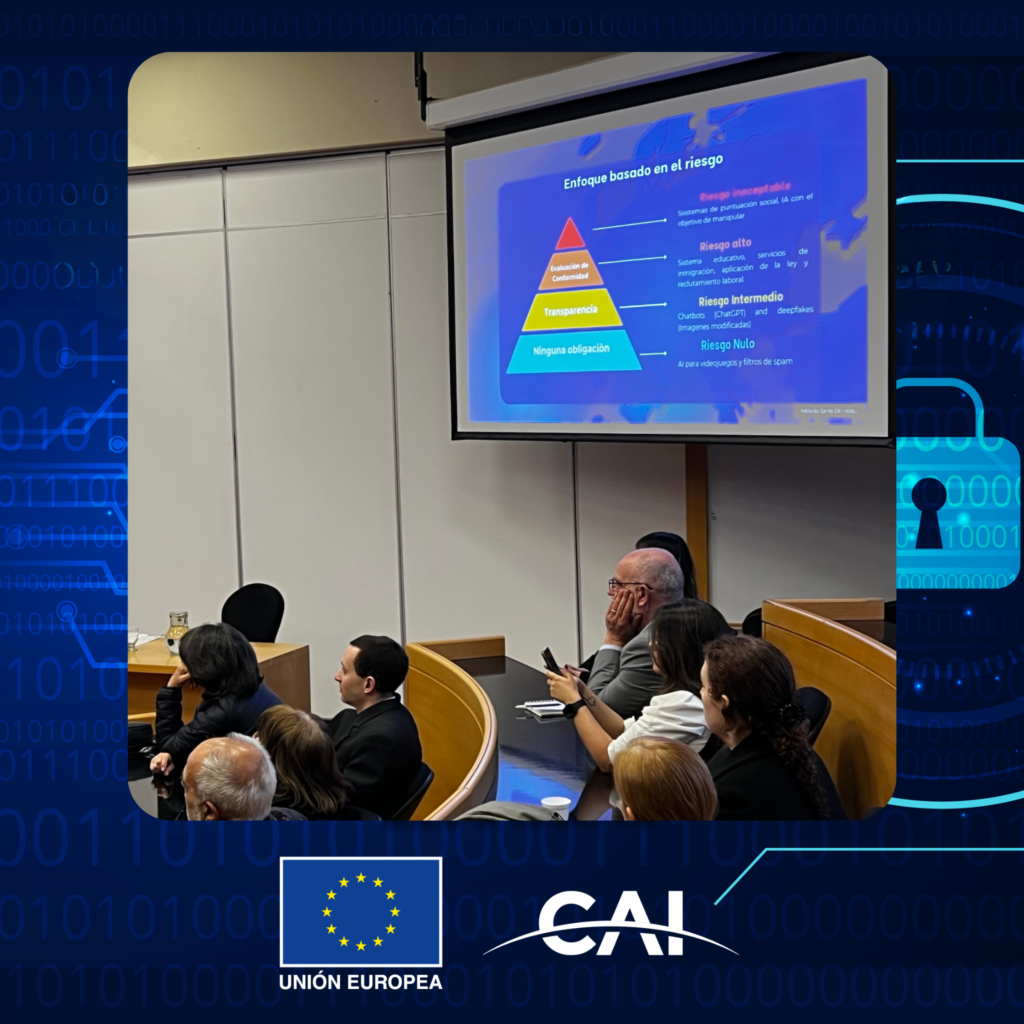

La Ley Europea de Inteligencia Artificial tiene como objetivo lograr un delicado equilibrio entre el fomento de la innovación tecnológica y la protección de los derechos fundamentales y la seguridad de los ciudadanos europeos. Introduce un marco integral que clasifica los riesgos de la IA en cuatro niveles distintos: inaceptable, alto, limitado y mínimo. Esta clasificación está diseñada para garantizar que las tecnologías de IA se desarrollen e implementen de manera responsable, minimizando el daño potencial y maximizando los beneficios.

El evento contó con la moderación de Amador Sánchez Rico, embajador de la Unión Europea en Argentina, quien brindó una explicación detallada del proceso de sanción de la ley y sus características únicas, destacando la importancia de la colaboración internacional para dar forma a las regulaciones de IA que sean efectivas y adaptables al panorama tecnológico en rápida evolución.

Los cuatro niveles de riesgo:

- Riesgo inaceptable: los sistemas de IA que representan una clara amenaza para la seguridad, los medios de vida o los derechos están prohibidos en esta categoría. Algunos ejemplos incluyen la IA para la calificación social por parte de los gobiernos o los sistemas que explotan las vulnerabilidades de grupos específicos.

- Riesgo alto: estos sistemas están sujetos a estrictas regulaciones y supervisión. Incluyen la IA utilizada en infraestructura crítica, educación, empleo y aplicación de la ley.

- Riesgo limitado: las aplicaciones de IA en esta categoría requieren transparencia y requisitos mínimos de cumplimiento. Los usuarios deben ser conscientes cuando interactúan con sistemas de IA.

- Riesgo mínimo: la mayoría de los sistemas de IA entran en esta categoría, con una intervención regulatoria mínima o nula.

Mientras la IA sigue permeando diversos aspectos de nuestras vidas, la Ley Europea de IA sirve como modelo para otras regiones que buscan implementar regulaciones similares. La charla enfatizó la necesidad de un diálogo continuo entre los responsables de las políticas, los tecnólogos y el público para garantizar que el desarrollo de la IA se alinee con los valores sociales y los estándares éticos.

La Ley Europea de IA es un paso pionero hacia la creación de un futuro digital más seguro y equitativo. Al abordar los desafíos de la regulación de la IA de frente, Europa está sentando un precedente para que lo sigan otras naciones. A medida que avanzamos, es crucial mantener una perspectiva global, fomentando la cooperación internacional para aprovechar todo el potencial de la IA al tiempo que se salvaguardan nuestros derechos fundamentales.